A causa del gran avenç

en les tecnologies d'informació, les organitzacions s'han hagut

d'enfrontar a nous reptes que els permetin analitzar, descobrir i entendre més

enllà del que les seves eines tradicionals reporten sobre la seva informació,

al mateix temps i durant els últims anys, el gran creixement de les aplicacions

disponibles a internet (geo-referenciamient, xarxes socials, etc) han estat

part important en les decisions de negoci de les empreses. Aquest article

pretén introduir el lector en el concepte de Big Data i descriure algunes

característiques dels components principals que constitueixen una solució

d'aquest tipus.

Introducció

El primer qüestionament que possiblement arribi a la seva

ment en aquest moment és, què és Big Data i per què s'ha tornat tan important? doncs

bé, en termes generals podríem referir com a la tendència en l'avanç de la

tecnologia que ha obert les portes cap a un nou enfocament d'entesa i presa de

decisions, la qual és utilitzada per a descriure enormes quantitats de dades

(estructurats, no estructurats i semi estructurats) que prendria massa temps i

seria molt costós carregar a un base de dades relacional per a la seva anàlisi. De

manera que, el concepte de Big Data s'aplica per a tota aquella informació

que no pot ser processada o analitzada utilitzant processos o eines tradicionals. No

obstant això, Big Data no es refereix a alguna quantitat en específic, ja que

és usualment utilitzat quan es parla en termes de petabytes i exabytes de

dades. Llavors quant és massa informació de manera que sigui elegible per

a ser processada i analitzada utilitzant el concepte de Big Data? Analitzem

primerament en termes de bytes:

Gigabyte = 10 9 =

1,000,000,000

Terabyte = 10 12 = 1,000,000,000,000

Petabyte = 10 15 = 1,000,000,000,000,000

exabytes = 10 18 = 1,000,000,000,000,000,000

Terabyte = 10 12 = 1,000,000,000,000

Petabyte = 10 15 = 1,000,000,000,000,000

exabytes = 10 18 = 1,000,000,000,000,000,000

A més del gran volum d'informació,

aquesta existeix en una gran varietat de

dades que poden ser representats de diverses maneres a tot el món, per exemple

de dispositius mòbils, àudio, vídeo, sistemes GPS, incomptables sensors

digitals en equips industrials, automòbils, mesuradors elèctrics, penells,

anemòmetres, etc, els quals poden mesurar i comunicar el posicionament,

moviment, vibració, temperatura, humitat i fins als canvis químics que pateix

l'aire, de manera que les aplicacions que analitzen aquestes dades requereixen

que la velocitat de

resposta sigui massa ràpida per aconseguir obtenir la informació correcta

en el moment precís. Aquestes són les característiques principals d'una oportunitat

per Big Data.

És important entendre que les bases de dades convencionals

són una part important i rellevant per a una solució analítica. De fet, es

torna molt més vital quan s'usa en conjunt amb la plataforma de Big Data. Pensem

en les nostres mans esquerra i dreta, cadascuna ofereix fortaleses individuals

per a cada tasca en específic. Per exemple, un jugador de beisbol, sap que

una de les seves mans és millor per llançar la pilota i l'altra per atrapar; pot

ser que cada mà intenti fer l'activitat de l'altra, mes no obstant això, el

resultat no serà el més òptim.

D'on prové tota aquesta informació?

Els éssers humans estem creant i emmagatzemant informació

constantment i cada vegada més en quantitats astronòmiques. Es podria dir

que si tots els bits i bytes de dades de l'últim any foren guardats en CD, es

generaria una gran torre des de la Terra fins a la Lluna i de tornada.

Aquesta contribució a l'acumulació massiva de dades la

podem trobar en diverses indústries, les companyies mantenen grans quantitats

de dades transaccionals, reunint informació sobre els seus clients, proveïdors,

operacions, etc, de la mateixa manera succeeix amb el sector públic. En

molts països s'administren enormes bases de dades que contenen dades de cens de

població, registres mèdics, impostos, etc, i si a tot això li afegim

transaccions financeres realitzades en línia o per dispositius mòbils, anàlisi

de xarxes socials (a Twitter són prop de 12 Terabytes de tweets creats

diàriament i Facebook emmagatzema al voltant de 100 Petabytes de fotos i

vídeos), la ubicació geogràfica mitjançant coordenades GPS, en altres paraules,

totes aquelles activitats que la majoria de nosaltres realitzem diverses

vegades al dia amb els nostres "smartphones", estem parlant que es

generen al voltant de 2.5 quintillons de bytes diàriament al món.

1 quintillón = 10 30 = 1,000,000,000,000,000,000,000,000,000,000

D'acord amb un estudi realitzat per Cisco, entre el 2011 i

el 2016 la quantitat de trànsit de dades mòbils creixerà a una taxa anual de

78%, així com el nombre de dispositius mòbils connectats a Internet excedirà el

nombre d'habitants en el planeta. Les nacions unides projecten que la

població mundial arribarà als 7.5 bilions per al 2016 de manera que hi haurà

prop de 18.9 bilions de dispositius connectats a la xarxa a escala mundial,

això comportaria que el trànsit global de dades mòbils abast 10.8 Exabytes

mensuals o 130 exabytes anuals. Aquest volum de trànsit previst per al

2016 equival a 33 bilions de DVDs anuals o 813 quadrilions de missatges de

text.

Però no només som els éssers humans els que contribuïm a aquest

creixement enorme d'informació, existeix també la comunicació anomenada màquina

a màquina (M2M machine-to-machine) el valor en la creació de grans quantitats

de dades també és molt important. Els sensors digitals instal·lats en

contenidors per determinar la ruta generada durant un lliurament d'algun paquet

i que aquesta informació sigui enviada a les companyies de transport, sensors

en mesuradors elèctrics per determinar el consum d'energia a intervals regulars

perquè sigui enviada aquesta informació a les companyies del sector energètic. S'estima

que hi ha més de 30 milions de sensors interconnectats en diferents sectors com

automoció, transport, industrial, serveis, comercial, etc. i s'espera que

aquest nombre creixi en un 30% anualment.

Quins tipus de dades he explorar?

Moltes organitzacions s'enfronten a la pregunta sobre quina

informació és la que s'ha d'analitzar ?, però, el qüestionament hauria d'estar

enfocat cap quin problema és el que s'està tractant de resoldre?

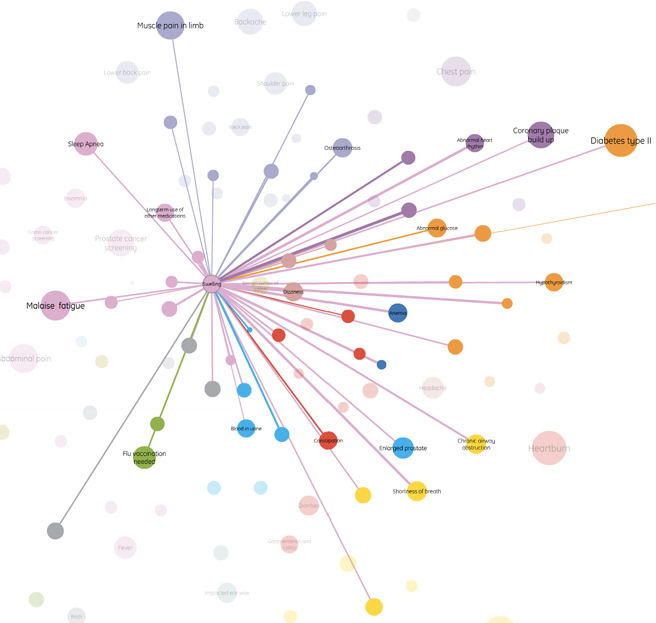

Si bé sabem que hi ha una àmplia varietat de tipus de dades

a analitzar, una bona classificació ens ajudaria a entendre millor la seva

representació, encara que és molt probable que aquestes categories puguin

estendre amb l'avanç tecnològic.

Tipus de dades de Big Data

![Tipus de dades de Big Data [2]](http://www.ibm.com/developerworks/ssa/local/im/que-es-big-data/Big-Data-Types.jpg)

2. Machine-to-Machine (M2M) : M2M es

refereix a les tecnologies que permeten connectar-se a altres dispositius. M2M

utilitza dispositius com sensors o mesuradors que capturen algun esdeveniment

en particular (velocitat, temperatura, pressió, variables meteorològiques,

variables químiques com la salinitat, etc) els quals transmeten a través de

xarxes amb fils, sense fils o híbrides a altres aplicacions que tradueixen

aquests esdeveniments en informació significativa.

3. Big Transaction Data : Inclou registres

de facturació, en telecomunicacions registres detallats de les trucades (CDR),

etc Aquestes dades transaccionals estan disponibles en formats tant

semiestructurats com no estructurats.

4. Biometrics : Informació biomètrica en

la qual s'inclou empremtes digitals, escaneig de la retina, reconeixement

facial, genètica, etc En l'àrea de seguretat i intel · ligència, les dades

biomètriques han estat informació important per a les agències d'investigació.

5. Human Generated : Les persones generem

diverses quantitats de dades com la informació que guarda un call center en

establir una trucada telefònica, notes de veu, correus electrònics, documents

electrònics, estudis mèdics, etc.

Components d'una plataforma Big Data

Les organitzacions han atacat aquesta problemàtica des de

diferents angles. Totes aquestes muntanyes d'informació han generat un

cost potencial en no descobrir el gran valor associat. Per descomptat,

l'angle correcte que actualment té el lideratge en termes de popularitat per

analitzar enormes quantitats d'informació és la plataforma de codi obert Hadoop.

Hadoop està inspirat en el

projecte de Google File System (GFS) i en el paradigma de programació MapReduce ,

el qual consisteix a dividir en dues tasques (

mapper - reducer ) per

manipular les dades distribuïdes a nodes d'un clúster aconseguint un alt

paral·lelisme en el processament. Hadoop està compost de tres peces: Hadoop

Distributed File System (HDFS), Hadoop MapReduce i Hadoop

Common.

Hadoop Distributed File System (HDFS)

Les dades en el clúster d'Hadoop són dividits en petites peces anomenades blocs i distribuïdes a través del clúster; d'aquesta manera, les funcions

Les dades en el clúster d'Hadoop són dividits en petites peces anomenades blocs i distribuïdes a través del clúster; d'aquesta manera, les funcions

map i redueix poden

ser executades en petits subconjunts i això proveeix de l'escalabilitat

necessària per al processament de grans volums.

La següent figura exemplifica com els blocs de dades són

escrits cap HDFS. Observi que cada bloc és emmagatzemat tres vegades i

almenys un bloc s'emmagatzema en un diferent rack per aconseguir redundància.

Exemple d'HDFS

Hadoop MapReduce

MapReduce és el nucli de

Hadoop. El terme MapReduce en realitat es refereix a dos processos

separats que Hadoop s'executa. El primer procés

map , el

qual pren un conjunt de dades i el converteix en un altre conjunt, on els

elements individuals són separats en tuples (parells

de clau / valor). El procés redueix obté

la sortida de map com a dades d'entrada i combina les

tuples en un conjunt més petit de les mateixes. Una fase intermèdia és

l'anomenada Shuffle la qual obté les

tuples del procés map i

determina que node processarà aquestes dades dirigint la sortida a una tasca redueix en

específic.

La següent figura exemplifica un flux de dades en un procés

senzill de MapReduce:

Big Data i el camp d'investigació

Els científics i investigadors han analitzat dades des de

ja fa molt temps, el que ara representa el gran repte és l'escala en què

aquests són generats.

Aquesta explosió de "grans dades" està

transformant la manera en què es condueix una investigació adquirint habilitats

en l'ús de Big Data per resoldre problemes complexos relacionats amb el

descobriment científic, recerca ambiental i biomèdica, educació, salut,

seguretat nacional, entre d'altres.

D'entre els projectes que es poden esmentar on s'ha dut a

terme l'ús d'una solució de Big Data es troben:

·

El Language,

Interaction and Computation Laboratory (CLIC) en conjunt amb

la Universitat de Trento a Itàlia, són un grup d'investigadors l'interès és

l'estudi de la comunicació verbal i no verbal tant amb mètodes computacionals

com cognitius.

·

Lineberger

Comprehensive Cancer Center - Bioinformatics Group utilitza

Hadoop i HBase per analitzar dades produïdes pels investigadors de The Cancer

Genome Atlas (TCGA) per suportar les investigacions

relacionades amb el càncer.

·

El PSG

College of Technology, l'Índia , analitza múltiples seqüències

de proteïnes per determinar els enllaços evolutius i predir estructures

moleculars. La naturalesa de l'algorisme i el paral · lelisme

computacional de Hadoop millora la velocitat i exactitud d'aquestes seqüències.

·

La Universitat

Distrital Francisco José de Caldas utilitza Hadoop per donar

suport al seu projecte de recerca relacionat amb el sistema d'intel·ligència

territorial de la ciutat de Bogotà.

·

La Universitat

de Maryland és una de les sis universitats que col·laboren en

la iniciativa acadèmica de còmput en el núvol d'IBM / Google.Les seves

investigacions inclouen projectes a la lingüística computacional (machine

translation), modelatge del llenguatge, bioinformàtica, anàlisi de correu

electrònic i processament d'imatges.

Per a més referències en l'ús de Hadoop pot dirigir-se a: http://wiki.apache.org/hadoop/PoweredBy

L'Institut

de Tecnologia de la Universitat d'Ontario (UOIT) juntament amb

l'Hospital de Toronto utilitzen una plataforma de big data per a anàlisi en

temps real d'IBM ( IBM

InfoSphere Streams ), la qual permet monitoritzar nadons

prematurs a les sales de neonatologia per determinar qualsevol canvi en la

pressió arterial, temperatura, alteracions en els registres de

l'electrocardiograma i electroencefalograma, etc, i així detectar fins a 24

hores abans aquelles condicions que puguin ser una amenaça a la vida dels

nounats.

Els laboratoris Pacific Northwest National Labs (PNNL) s'utilitzen

de la mateixa manera IBM InfoSphere Streams per analitzar esdeveniments de

mesuradors de la seva xarxa elèctrica i en temps real verificar aquelles

excepcions o falles en els components de la xarxa, aconseguint comunicar

gairebé de manera immediata als consumidors sobre el problema per ajudar a

administrar el seu consum d'energia elèctrica.

L'esclerosi múltiple és una malaltia del sistema nerviós

que afecta el cervell i la medul·la espinal. La comunitat de recerca

biomèdica i la Universitat

de l'Estat de Nova York (SUNY) estan aplicant anàlisi amb big

data per contribuir a la progressió de la investigació, diagnòstic, tractament,

i potser fins a la possible cura de l'esclerosi múltiple.

Amb la capacitat de generar tota aquesta informació valuosa

de diferents sistemes, les empreses i els governs estan bregant amb el problema

d'analitzar les dades per a dos propòsits importants: ser capaços de detectar i

respondre als esdeveniments actuals d'una manera oportuna, i per poder

utilitzar les prediccions de l'aprenentatge històric. Aquesta situació

requereix de l'anàlisi tant de dades en moviment (dades actuals) com de dades

en repòs (dades històriques), que són representats a diferents i enormes

volums, varietats i velocitats.

Conclusions

La naturalesa de la informació avui és diferent a la

informació en el passat. A causa de la abundància de sensors, micròfons,

càmeres, escàners mèdics, imatges, etc en les nostres vides, les dades

generades a partir d'aquests elements seran d'aquí a poc el segment més gran de

tota la informació disponible.

L'ús de Big Data ha ajudat els investigadors a descobrir coses que els podrien haver pres anys a descobrir per si mateixos sense l'ús d'aquestes eines, a causa de la velocitat de l'anàlisi, és possible que l'analista de dades pugui canviar les seves idees basant-se en el resultat obtingut i retrabajar el procediment una vegada i una altra fins a trobar el veritable valor al que s'està tractant d'arribar .

L'ús de Big Data ha ajudat els investigadors a descobrir coses que els podrien haver pres anys a descobrir per si mateixos sense l'ús d'aquestes eines, a causa de la velocitat de l'anàlisi, és possible que l'analista de dades pugui canviar les seves idees basant-se en el resultat obtingut i retrabajar el procediment una vegada i una altra fins a trobar el veritable valor al que s'està tractant d'arribar .

Com es va poder notar en el present article, implementar

una solució al voltant de Big Data implica de la integració de diversos

components i projectes que en conjunt formen l'ecosistema necessari per

analitzar grans quantitats de dades.

Sense una plataforma de Big Data es necessitaria desenvolupar addicionalment codi que permeti administrar cada un d'aquests components com ara: maneig d'esdeveniments, connectivitat, alta disponibilitat, seguretat, optimització i desenvolupament, depuració, monitorització, administració de les aplicacions, SQL i scripts personalitzats.

Sense una plataforma de Big Data es necessitaria desenvolupar addicionalment codi que permeti administrar cada un d'aquests components com ara: maneig d'esdeveniments, connectivitat, alta disponibilitat, seguretat, optimització i desenvolupament, depuració, monitorització, administració de les aplicacions, SQL i scripts personalitzats.

IBM compta amb una plataforma de Big Data basada en dos productes principals: IBM InfoSphere BigInsights ™ i IBM InfoSphere Streams ™, a més de la seva recent adquisició Vivisimo, els quals estan dissenyats per resoldre aquest tipus de problemes. Aquestes eines estan construïdes per ser executades en sistemes distribuïts a gran escala dissenyats per tractar amb grans volums d'informació, analitzant tant dades estructurades com no estructurats.

Dins de la plataforma d'IBM ha més de 100 aplicacions d'exemple

recollides de la feina que s'ha realitzat internament en l'empresa per casos

d'ús i indústries específiques. Aquests aplicatius estan implementats dins

de la solució de manera que les organitzacions puguin dedicar el seu temps a

analitzar i no a implementar.

Font:IBM

Cap comentari:

Publica un comentari a l'entrada

Aquest és un blog amb moderador dels comentaris. Per tant, no apareixen immediatament