Més de 50.000 usuaris de 27 empreses ja utilitzen aquesta solució que garanteix la seguretat de les dades i permet interoperar amb els sistemes transaccionals.

Aggity, multinacional espanyola de solucions digitals especialitzada en la transformació digital i la socialització de l'empresa, s'ha avançat a l'arribada al mercat de WhatsApp Business, amb la seva solució Corporate Messenger by Aggity, disponible des del març de l'any passat i actualment utilitzada o en fase d'adopció per 27 empreses, tant a Espanya com a Llatinoamèrica, sumant un total de més de 50.000 usuaris en els sectors de salut, indústria, serveis i retail, entre d'altres.

Sota el model Social Business, Corporate Messenger by Aggity és un sistema de comunicació i col·laboració privat, segur i confidencial basat en missatgeria instantània i vídeo-streaming, que permet la comunicació omnidireccional i la col·laboració entre tots els membres de l'ecosistema de les organitzacions, inclosos empleats, col·laboradors, clients, proveïdors, organitzacions externes relacionades, etc. a través d'una solució personalitzada i amb marca blanca per a cada client.

Dissenyada per garantir a l'empresa el control i la seguretat de les dades, permet interoperar amb els sistemes transaccionals de la companyia de manera que, a més de facilitar la connexió de les empreses amb els seus clients, és una via addicional de comunicació, tant amb processos com amb coses, sota una interfície totalment adaptada a la imatge corporativa de l'organització. Compleix amb la Llei de Protecció de Dades (LOPD), així com la nova regulació europea General Data Protection Regulation (GDPR) i, de fet, aquest és un dels aspectes més valorats pels seus usuaris.

Segons Oscar Pierre, president i CEO d'Aggity , "tenim clar que una empresa no podrà ser digital si abans no és social i les nostres solucions Social Business permeten realitzar aquest canvi en la gestió de manera senzilla i ràpida". Així, "Corporate Messenger by Aggity permet a les empreses aprofitar els múltiples avantatges de la comunicació social sense posar en risc la integritat i confidencialitat de les seves dades".

"Després de gairebé dos anys de l'anunci de Whatsapp Business", afegeix Pierre, "la versió per a empreses de Whatsapp està tenint dificultats per arrelar perquè ha heretat l'enfocament de Facebook WorkSpace, les dades continuen pertanyent a Facebook i, a més, no ofereix interoperabilitat amb sistemes transaccionals ni s'adapta al model de cloud híbrida".

Corporate Messenger by Aggity forma part de la gamma de solucions Social Business d'Aggity, que ha permès als seus clients aprofitar el coneixement i ús massiu de les eines de comunicació, col·laboració i xarxes socials i traslladar-lo a un entorn segur i confidencial dins de l'empresa per desenvolupar una gestió col·laborativa. A més, aquestes eines i integren i combinen al seu torn amb sistemes transaccionals i de gestió tradicionals (ERP, CRM, CMS), tecnologies de mobilitat, anàlisi intel·ligent de la informació (Big Data) i IoT, creant així un nou ecosistema de gestió digital i social.

Les empreses clients d'Aggity que ja utilitzen els seus apps socials en la seva gestió destaquen, a més dels estalvis de costos, altres avantatges relacionats amb la millora de la productivitat i dels ingressos, gràcies a l'augment de la motivació del personal i de la satisfacció dels clients. En aquest sentit, l'experiència de les organitzacions usuàries demostra que una millor comunicació i col·laboració mitjançant tecnologies socials poden augmentar la productivitat dels treballadors en una forquilla d'entre un 20% i un 25%.

Les empreses usuàries de les solucions Social Business d'Aggity valoren específicament, de l'entorn de gestió digital a través de solucions Social Business, la capacitat per accelerar la innovació interna i el llançament de nous productes i serveis, campanyes de màrqueting i promocions, així com la generació de noves oportunitats de negoci. També identifiquen millores en la transparència i el coneixement col·lectiu, així com en la localització i potenciació de talent.

Font: RedesTelecom

divendres, 29 de desembre del 2017

Corporate Messenger by aggity, la competència espanyola a WhatsApp Business

Etiquetes de comentaris:

Aggity,

Corporate Messenger by Aggity,

WhatsApp

Ubicació:

Granollers, Barcelona, Espanya

Els investigadors troben una nova forma de manipular el magnetisme

En un esforç pioner per controlar, mesurar i comprendre el magnetisme a nivell atòmic, els investigadors que treballen a l'Institut Nacional d'Estàndards i Tecnologia (NIST) han descobert un nou mètode per manipular les propietats nanomètriques dels materials magnètics.

La capacitat de controlar aquestes propietats té aplicacions potencials en la creació i millora de la memòria magnètica en els dispositius electrònics de consum, i en el desenvolupament d'un detector sensible per a les nanopartícules magnètiques.

El descobriment se centra en una propietat mecànica quàntica coneguda com spin, que proporciona electrons amb un petit camp magnètic. L'spin electrònic pot apuntar en dues direccions, up o down, igual que el camp magnètic que l'acompanya. Amb els anys, els científics s'han convertit en experts en fer girar la direcció de la rotació i, per tant, la direcció del camp magnètic. Però la nova troballa té un nou gir.

En alguns materials, com el cobalt, els spins dels electrons veïns interactuen fent que tots apuntin en la mateixa direcció. Si alguns dels girs es veuen obligats a allunyar-se d'aquesta direcció, arrenquen alguns dels girs propers amb ells. Això fa que els girs siguin un gir gradual en el sentit de les agulles del rellotge. En alguns materials, els girs prefereixen girar en una sola direcció.

Un equip liderat per l'investigador de NIST, Samuel Stavis i Andrew Balk, ara al Laboratori Nacional de Los Alamos, va trobar una manera de controlar la direcció d'aquest gir en una pel·lícula de cobalt de només tres capes atòmiques de gruix. A més, podrien configurar aquesta direcció en diferents llocs de la mateixa pel·lícula de cobalt, i fer-ho independentment d'altres propietats magnètiques del metall.

L'equip ha aconseguit aquesta nova capacitat controlant un efecte conegut com la interacció Dzyaloshinskii-Moriya (DMI), que imposa una direcció de gir preferida sobre els spins. El DMI sol presentar-se al límit entre una pel·lícula prima d'un metall magnètic i una capa metàl·lica no magnètica. Els girs electrònics de la pel·lícula magnètica interactuen amb els àtoms de la pel·lícula no magnètica creant un gir preferent.

El control del DMI pot augmentar la memòria magnètica, que utilitza la orientació de l'spin per emmagatzemar informació. Un dispositiu de memòria necessita dos estats diferents, que representen un o zero, en el cas d'un disc dur magnètic, electrons amb spin apuntant cap amunt o cap avall. Per escriure dades, els dissenyadors necessiten una forma predictible de passar d'una orientació de gir a l'altra. Controlar la direcció i la quantitat de gir permeten que el flux d'spin passi de manera més eficient i fiable que si el gir fos aleatori.

El control del DMI també juga un paper clau en un altre tipus de memòria magnètica. Si el DMI és prou fort, girarà els girs propers a un patró de vòrtex circular i podria crear nusos magnètics exòtics anomenats skyrmions. Aquests nusos com partícules poden emmagatzemar informació, i la seva existència o absència en una pel·lícula prima magnètica podria actuar molt com els cercles i els circuits lògics electrònics.

Mitjançant la regulació del DMI, els investigadors poden crear cel·lulars que requeriran menys energia per a funcionar que altres tipus de memòria magnètica i han de poder guiar el seu moviment a través d'un material magnètic.

Els investigadors descriuen el seu treball al Physical Review Letters

En el seu experiment, els investigadors van llançar una fina capa de cobalt entre dues capes de platí, un metall no magnètic. A continuació, van bombardejar el trilayer amb ions d'argó, que van espatllar la pel·lícula de platí superior i van rugir el límit superior entre el platí i el cobalt, depenent de l'energia iònica. Els científics van descobrir que quan s'utilitzen ions d'argó amb una energia més alta, la DMI va ser negatiu, retorçant els espins de cobalt en sentit antihorari, i quan s'utilitzen ions d'argó amb l'energia més baixa, la DMI va ser positiva, i es reforcen els girs en direcció del sentit horari. Quan es va exposar a ions argònics d'energia intermèdia, el DMI era zero, pel que és igualment probable que els girs es giren a la dreta o a l'esquerra.

Els investigadors van fer el seu descobriment mentre sintonitzaven les propietats magnètiques d'una pel·lícula de cobalt per desenvolupar un sensor per a nanopartícules magnètiques. En fer-ho, l'equip es va adonar que havia trobat una nova forma de manipular el DMI.

Com que els ions d'argó amb diferents energies podrien estar dirigits a regions específiques dins del cobalt, els investigadors van poder fabricar pel·lícules de cobalt, la DMI variava a través de la superfície del material.

"Sis dècades després que Dzyaloshinskii i Moriya descobreixin aquesta interacció, el nostre nou procés de control espacial, independentment d'altres propietats magnètiques, permetrà nous estudis científics del DMI i permetrà la fabricació de nous dispositius nanomagnètics", va dir Balk.

Finalment, els científics van trobar que controlar el DMI va fer que la pel·lícula fos més sensible als camps magnètics de les nanopartícules. Més endavant, l'equip planeja publicar treballs sobre l'aplicació de la pel·lícula com a sensor de nanopartícules per als usuaris del Centre NIST per a la ciència i la tecnologia nanoescala, on es va realitzar el treball.

Font: PHYSorg

La capacitat de controlar aquestes propietats té aplicacions potencials en la creació i millora de la memòria magnètica en els dispositius electrònics de consum, i en el desenvolupament d'un detector sensible per a les nanopartícules magnètiques.

El descobriment se centra en una propietat mecànica quàntica coneguda com spin, que proporciona electrons amb un petit camp magnètic. L'spin electrònic pot apuntar en dues direccions, up o down, igual que el camp magnètic que l'acompanya. Amb els anys, els científics s'han convertit en experts en fer girar la direcció de la rotació i, per tant, la direcció del camp magnètic. Però la nova troballa té un nou gir.

En alguns materials, com el cobalt, els spins dels electrons veïns interactuen fent que tots apuntin en la mateixa direcció. Si alguns dels girs es veuen obligats a allunyar-se d'aquesta direcció, arrenquen alguns dels girs propers amb ells. Això fa que els girs siguin un gir gradual en el sentit de les agulles del rellotge. En alguns materials, els girs prefereixen girar en una sola direcció.

Un equip liderat per l'investigador de NIST, Samuel Stavis i Andrew Balk, ara al Laboratori Nacional de Los Alamos, va trobar una manera de controlar la direcció d'aquest gir en una pel·lícula de cobalt de només tres capes atòmiques de gruix. A més, podrien configurar aquesta direcció en diferents llocs de la mateixa pel·lícula de cobalt, i fer-ho independentment d'altres propietats magnètiques del metall.

L'equip ha aconseguit aquesta nova capacitat controlant un efecte conegut com la interacció Dzyaloshinskii-Moriya (DMI), que imposa una direcció de gir preferida sobre els spins. El DMI sol presentar-se al límit entre una pel·lícula prima d'un metall magnètic i una capa metàl·lica no magnètica. Els girs electrònics de la pel·lícula magnètica interactuen amb els àtoms de la pel·lícula no magnètica creant un gir preferent.

El control del DMI pot augmentar la memòria magnètica, que utilitza la orientació de l'spin per emmagatzemar informació. Un dispositiu de memòria necessita dos estats diferents, que representen un o zero, en el cas d'un disc dur magnètic, electrons amb spin apuntant cap amunt o cap avall. Per escriure dades, els dissenyadors necessiten una forma predictible de passar d'una orientació de gir a l'altra. Controlar la direcció i la quantitat de gir permeten que el flux d'spin passi de manera més eficient i fiable que si el gir fos aleatori.

El control del DMI també juga un paper clau en un altre tipus de memòria magnètica. Si el DMI és prou fort, girarà els girs propers a un patró de vòrtex circular i podria crear nusos magnètics exòtics anomenats skyrmions. Aquests nusos com partícules poden emmagatzemar informació, i la seva existència o absència en una pel·lícula prima magnètica podria actuar molt com els cercles i els circuits lògics electrònics.

Mitjançant la regulació del DMI, els investigadors poden crear cel·lulars que requeriran menys energia per a funcionar que altres tipus de memòria magnètica i han de poder guiar el seu moviment a través d'un material magnètic.

Els investigadors descriuen el seu treball al Physical Review Letters

En el seu experiment, els investigadors van llançar una fina capa de cobalt entre dues capes de platí, un metall no magnètic. A continuació, van bombardejar el trilayer amb ions d'argó, que van espatllar la pel·lícula de platí superior i van rugir el límit superior entre el platí i el cobalt, depenent de l'energia iònica. Els científics van descobrir que quan s'utilitzen ions d'argó amb una energia més alta, la DMI va ser negatiu, retorçant els espins de cobalt en sentit antihorari, i quan s'utilitzen ions d'argó amb l'energia més baixa, la DMI va ser positiva, i es reforcen els girs en direcció del sentit horari. Quan es va exposar a ions argònics d'energia intermèdia, el DMI era zero, pel que és igualment probable que els girs es giren a la dreta o a l'esquerra.

Els investigadors van fer el seu descobriment mentre sintonitzaven les propietats magnètiques d'una pel·lícula de cobalt per desenvolupar un sensor per a nanopartícules magnètiques. En fer-ho, l'equip es va adonar que havia trobat una nova forma de manipular el DMI.

Com que els ions d'argó amb diferents energies podrien estar dirigits a regions específiques dins del cobalt, els investigadors van poder fabricar pel·lícules de cobalt, la DMI variava a través de la superfície del material.

"Sis dècades després que Dzyaloshinskii i Moriya descobreixin aquesta interacció, el nostre nou procés de control espacial, independentment d'altres propietats magnètiques, permetrà nous estudis científics del DMI i permetrà la fabricació de nous dispositius nanomagnètics", va dir Balk.

Finalment, els científics van trobar que controlar el DMI va fer que la pel·lícula fos més sensible als camps magnètics de les nanopartícules. Més endavant, l'equip planeja publicar treballs sobre l'aplicació de la pel·lícula com a sensor de nanopartícules per als usuaris del Centre NIST per a la ciència i la tecnologia nanoescala, on es va realitzar el treball.

Font: PHYSorg

Etiquetes de comentaris:

nanopartícules magnètiques

Ubicació:

Granollers, Barcelona, Espanya

Una nova tecnologia podria revolucionar l'ús del telèfon intel·ligent

Una tecnologia innovadora, creada per investigadors de la Universitat de Sant Andrews, pot permetre que el telèfon intel·ligent realitzi una sèrie de tasques amb només reconèixer la superfície en què està.

SpeCam és un programa que permetrà als telèfons existents utilitzar la seva funció de càmera per reconèixer diferents materials als quals està exposat. Això es relacionaria amb una base de dades prèviament creada perquè el telèfon pugui entendre sobre quin tipus de superfície s'ha col·locat.

Ofereix una àmplia gamma d'aplicacions perquè el telèfon no us digui on és quan no el trobeu; per programar-lo perquè detecti diferents superfícies com a activador d'acció. Per exemple, si el telèfon sona i el posa cap per avall a l'ordinador portàtil, podria enviar un missatge dient "em sap greu, estic en una reunió" o si es posa a la butxaca podria suggerir que es truqui a un altre company.

El programa també permetria que el telèfon es programi per dur a terme tasques, com ara canviar el volum de la televisió o tocar determinades músiques com ara el soft jazz si es col·loca al sofà o la música de ball si és a la taula d'una cafeteria.

Com que el maquinari necessari ja existeix en els telèfons intel·ligents moderns, el sistema SpeCam podria estar habilitat a través d'una actualització de programari o descàrrega d'aplicacions.

La investigació es va presentar a la prestigiosa 19a Conferència Internacional sobre Interacció Humana-Informàtica amb Dispositius i Serveis Mòbils, ACM SIGCHI MobileHCI 2017, al setembre passat a Viena (Àustria). El document SpeCam: detecció de color de superfície i material amb la càmera frontal d'un dispositiu mòbil ha rebut un premi d'honor al MobileHCI, un dels només cinc documents d'aquest tipus en tot el programa.

L'investigador principal, el professor Aaron Quigley, president del Human Computer Interaction at the University, va dir: "Aquest és un exemple del que anomenem Computació Discreta o interacció discreta, on les accions d'usuaris subtils i discretes poden provocar formes d'interacció completament noves. Per tant, reconèixer materials i totes les superfícies que ens envolten, els converteixen en un llenç per la nostra imaginació".

SpeCam utilitza intel·ligentment la pantalla en un telèfon intel·ligent com a font de llum multiespectral i la càmera frontal per capturar la reflexió del material que s'ha col·locat cap amunt.

El programa permet que la pantalla passi ràpidament a través de diferents colors per il·luminar l'objecte, detectar el material i inferir la ubicació del dispositiu.

Hui Yeo, la investigadora que va dur a terme aquesta investigació, va afegir: "L'objectiu és explorar noves formes d'interacció per a ús individual que puguin aprofitar el que la gent ja fa amb els dispositius, sense afegir cap maquinari nou al dispositiu".

Font: St. Andrews University

SpeCam és un programa que permetrà als telèfons existents utilitzar la seva funció de càmera per reconèixer diferents materials als quals està exposat. Això es relacionaria amb una base de dades prèviament creada perquè el telèfon pugui entendre sobre quin tipus de superfície s'ha col·locat.

Ofereix una àmplia gamma d'aplicacions perquè el telèfon no us digui on és quan no el trobeu; per programar-lo perquè detecti diferents superfícies com a activador d'acció. Per exemple, si el telèfon sona i el posa cap per avall a l'ordinador portàtil, podria enviar un missatge dient "em sap greu, estic en una reunió" o si es posa a la butxaca podria suggerir que es truqui a un altre company.

El programa també permetria que el telèfon es programi per dur a terme tasques, com ara canviar el volum de la televisió o tocar determinades músiques com ara el soft jazz si es col·loca al sofà o la música de ball si és a la taula d'una cafeteria.

Com que el maquinari necessari ja existeix en els telèfons intel·ligents moderns, el sistema SpeCam podria estar habilitat a través d'una actualització de programari o descàrrega d'aplicacions.

La investigació es va presentar a la prestigiosa 19a Conferència Internacional sobre Interacció Humana-Informàtica amb Dispositius i Serveis Mòbils, ACM SIGCHI MobileHCI 2017, al setembre passat a Viena (Àustria). El document SpeCam: detecció de color de superfície i material amb la càmera frontal d'un dispositiu mòbil ha rebut un premi d'honor al MobileHCI, un dels només cinc documents d'aquest tipus en tot el programa.

L'investigador principal, el professor Aaron Quigley, president del Human Computer Interaction at the University, va dir: "Aquest és un exemple del que anomenem Computació Discreta o interacció discreta, on les accions d'usuaris subtils i discretes poden provocar formes d'interacció completament noves. Per tant, reconèixer materials i totes les superfícies que ens envolten, els converteixen en un llenç per la nostra imaginació".

SpeCam utilitza intel·ligentment la pantalla en un telèfon intel·ligent com a font de llum multiespectral i la càmera frontal per capturar la reflexió del material que s'ha col·locat cap amunt.

El programa permet que la pantalla passi ràpidament a través de diferents colors per il·luminar l'objecte, detectar el material i inferir la ubicació del dispositiu.

Hui Yeo, la investigadora que va dur a terme aquesta investigació, va afegir: "L'objectiu és explorar noves formes d'interacció per a ús individual que puguin aprofitar el que la gent ja fa amb els dispositius, sense afegir cap maquinari nou al dispositiu".

Font: St. Andrews University

Etiquetes de comentaris:

SpeCam

Ubicació:

Granollers, Barcelona, Espanya

La digitalització de les renovables, clau per complir els objectius per al 2020

Espanya haurà de realitzar un esprint final si vol complir els objectius en matèria d'energies renovables que fixa la Unió Europea. Aquests compromisos, van ser marcats per a tots els països de la UE, imposant l'objectiu que almenys un 20% de l'energia consumida a cada estat membre provingués de fonts renovables. Segons les dades de Kaiserwetter, empresa internacional dedicada a la gestió tècnica i comercial de parcs eòlics i fotovoltaics, Espanya es troba actualment en el lloc 14 de la UE-28, amb un 16,2% de la demanda coberta per energies renovables, per sota de la mitjana europea del 16,7%, i a 3,8 punts de l'objectiu del 2020.

És el moment que els actors inverteixin en noves eines digitals, segons Kaiserwetter

Tot i que durant els primers anys de l'entrada en vigor la directiva Espanya va viure un boom de les renovables que la va encaminar a complir l'objectiu, passant en deu anys d'un 9,2% (2006) a l'actual 16,2%, la situació ha canviat després de gairebé tres anys amb una inversió gairebé nul·la; la crisi econòmica i traves legals com el conegut com a 'Impost al sol'. Per revertir aquesta tendència i complir els objectius legals europeus, el govern ha adjudicat en només un any i mig un total de 8.737 MW de nova potència verda. Només al juliol passat, el Ministeri d'Energia va adjudicar a un grup de 40 empreses un total 5.037 MW (3.909 MW a instal·lacions fotovoltaiques i 1.128 MW a eòliques) i realitzarà una altra subhasta per a les illes.

Companyies com Kaiserwetter, experta en la digitalització del sector mitjançant la seva innovadora plataforma digital Aristòtil, assenyalen que aquest canvi de tendència tornarà a situar a Espanya, actualment cinquè productor de renovables de la UE, com a referent dels inversors i que, per això, és el moment que els actors inverteixin en noves eines digitals. D'altra banda, és previsible que aquesta reactivació comporti a una caiguda dels preus del mercat majorista. Eines com Aristòtil permeten mantenir els marges de benefici mitjançant la integració de dades tècniques i financers que prescindeixin dels departaments de controlling o amb la capacitat de detectar els components de les plantes menys eficients, l'optimització del seu rendiment i la realització de simulacions. Ofereix la possibilitat de gestionar en temps real.

Si totes les instal·lacions per a la nova potència assignada pel Govern es construeixen d'aquí al 2020, Espanya complirà els compromisos de la UE, però l'estret marge de temps per al muntatge de totes aquestes plantes planteja complicacions logístiques que situen aquestes eines digitals part d'un procés irreversible i una opció òbvia per superar-les mitjançant optimització, eficiència i estalvi en costos.

Font: Interempresas

És el moment que els actors inverteixin en noves eines digitals, segons Kaiserwetter

Tot i que durant els primers anys de l'entrada en vigor la directiva Espanya va viure un boom de les renovables que la va encaminar a complir l'objectiu, passant en deu anys d'un 9,2% (2006) a l'actual 16,2%, la situació ha canviat després de gairebé tres anys amb una inversió gairebé nul·la; la crisi econòmica i traves legals com el conegut com a 'Impost al sol'. Per revertir aquesta tendència i complir els objectius legals europeus, el govern ha adjudicat en només un any i mig un total de 8.737 MW de nova potència verda. Només al juliol passat, el Ministeri d'Energia va adjudicar a un grup de 40 empreses un total 5.037 MW (3.909 MW a instal·lacions fotovoltaiques i 1.128 MW a eòliques) i realitzarà una altra subhasta per a les illes.

Companyies com Kaiserwetter, experta en la digitalització del sector mitjançant la seva innovadora plataforma digital Aristòtil, assenyalen que aquest canvi de tendència tornarà a situar a Espanya, actualment cinquè productor de renovables de la UE, com a referent dels inversors i que, per això, és el moment que els actors inverteixin en noves eines digitals. D'altra banda, és previsible que aquesta reactivació comporti a una caiguda dels preus del mercat majorista. Eines com Aristòtil permeten mantenir els marges de benefici mitjançant la integració de dades tècniques i financers que prescindeixin dels departaments de controlling o amb la capacitat de detectar els components de les plantes menys eficients, l'optimització del seu rendiment i la realització de simulacions. Ofereix la possibilitat de gestionar en temps real.

Si totes les instal·lacions per a la nova potència assignada pel Govern es construeixen d'aquí al 2020, Espanya complirà els compromisos de la UE, però l'estret marge de temps per al muntatge de totes aquestes plantes planteja complicacions logístiques que situen aquestes eines digitals part d'un procés irreversible i una opció òbvia per superar-les mitjançant optimització, eficiència i estalvi en costos.

Font: Interempresas

Etiquetes de comentaris:

digitalització,

energies renovables

Ubicació:

Granollers, Barcelona, Espanya

Modelització dels canvis minúsculs d'una ciutat

Mitjançant l'ús de models 3D, els científics computacionals poden crear representacions estàtiques i precises d'una ciutat. No obstant això les ciutats, igual que els éssers vius, gairebé sempre estan en moviment. Els principals projectes de construcció -des de nous edificis fins a infraestructures de transport públic- esdeveniments sísmics o construccions de mala qualitat poden alterar ràpidament les propietats de la ciutat tant per sobre com per sota del sòl.

Un equip d'investigadors liderats pel professor Xiaoxiang Zhu, de la Universitat Tècnica de Munich (TUM), va reconèixer que el modelatge amb precisió de les ciutats per a propòsits de gestió de riscos necessitaven una quarta dimensió: el temps. Per posar-ho en marxa amb una alta resolució d'un model tridimensional, l'equip necessitava l'ajuda de superordinadors.

"Els models estàtics tridimensionals de les ciutats estan ben establerts, sobretot a Europa", va dir Zhu. "El que ara treballem en la mesura dels canvis temporals és fins a l'escala de centímetre o mil·límetre per observar si les àrees d'edificis s'han vist pertorbades per l'augment o la disminució".

L'augment i la subsidència són el moviment de la superfície de la Terra en funció de les condicions canviants subterrànies, poden moure les estructures cap amunt (augment) o cap avall (subsidència). Utilitzant algunes de les tecnologies d'imatges de satèl·lit més avançades a la Terra i la màquina SuperMUC del Centre de Supercomputació de Leibniz (LRZ), l'equip de Zhu pren fotografies satel·litals d'aquests petits canvis, i després utilitza aquestes imatges per fer models computacionals en moviment.

En el procés, l'equip va reconstruir el primer model que il·lustra tota una ciutat en quatre dimensions. La investigació de l'equip va rebre el millor premi paper de les transaccions IEEE sobre Geoscience i teledetecció l'estiu passat.

Reconstrucció de riscos de construcció

La investigació de l'equip comença per sobre dels núvols. Usant alguns dels satèl·lits d'observació civil més avançats disponibles, com ara TerraSAR-X i TanDEM-X del Centre Aeroespacial Alemany (DLR), el grup utilitza un mètode anomenat tomografia SAR (TomoSAR) per obtenir les seves imatges en 3D.

Per mesurar els canvis dels edificis, aquests satèl·lits han de disparar ones a la superfície de la terra, alhora que mesuren la distància entre el satèl·lit i els edificis de la zona en qüestió: com més curta sigui la longitud d'ona, més precises són les mesures. L'equip Zhu utilitza imatges creades amb ones de 3 centímetres.

El satèl·lit triga uns 11 dies a revisar el mateix lloc a la Terra, després pren una imatge des d'una posició una mica diferent, permetent als investigadors combinar aquestes imatges en un model 3D. A més, atès que les imatges es prenen en diferents moments, aquestes mesures precises permeten als investigadors buscar "paràmetres de deformació" observant fins i tot els canvis més mínims -en aquest context, l'anomenada quarta dimensió- a la distància de l'edifici del satèl·lit.

Els investigadors es posen a treballar per posar aquestes imatges en moviment. Cada imatge és aproximadament 10,000 per 5.000 píxels, i l'equip ha de fer càlculs per a cada píxel. L'equip ha treballat en conjunts de dades per a diverses ciutats -Las Vegas, Berlín, Xangai, Beijing, Washington DC i París- i té conjunts de dades que van des d'aproximadament 25 imatges fins a 550.

El mètode de detecció de compressió de l'equip és una de les claus en la generació d'aquests models de 4D d'alta qualitat. En termes simples, mitjançant l'ús de la detecció compressiva, els investigadors es beneficien de la sparsity del model o el fet que només estiguin recreant un model tridimensional de la superfície de la Terra en lloc del volum sencer del planeta. Això permet als investigadors augmentar la resolució en els seus models fins a 25 vegades el que podrien fer simulant el volum de la Terra.

"Els preus que vam pagar per aquests models de ciutats 4D precisos i rècord mundials són despeses computacionals", va dir Zhu. "Per a cada píxel, estem resolent un costós problema d'optimització convexa amb una dimensió de centenars de milions de vegades. Això només és possible amb una informàtica d'alt rendiment".

L'equip va utilitzar 26 milions d'hores bàsiques en el sistema SuperMUC de LRZ. Aquests models són molt intensius en la memòria, i l'equip utilitza l'illa greix de SuperMUC, de manera que podria centrar les seves reconstruccions en els 8.200 nuclis de la màquina amb una memòria molt alta per nucli.

Ronda i volta

Com que va ser el primer equip a crear models 4D a partir de dades d'imatges de satèl·lit, l'equip ha ajudat a començar un camí per obtenir mètodes més detallats i de vigilància de la ciutat. En crear els seus diferents models de ciutats, l'equip va descobrir que el centre de convencions de Las Vegas mostrava una disminució notable, i el sòl s'enfonsava aproximadament a 30 mil·límetres per any en alguns llocs.

A mesura que les ciutats continuen augmentant i arriben a ser cada cop més poblades, es prenen imatges d'alta resolució de l'espai i el poder informàtic continua creixent, l'equip confia que els seus mètodes s'utilitzaran amb més freqüència, cosa que conduirà a treballs de construcció més segurs i avançats, avís d'edificis que comencen a mostrar signes de risc estructural i, al seu torn, perill.

L'equip ha estat guardonat amb una altra assignació de l'equip GCS per al 2017, que rep 20 milions d'hores bàsiques en el sistema SuperMUC de LRZ. Zhu va indicar que l'equip va planificar obrir els conjunts de dades de l'equip a la comunitat perquè altres investigadors poguessin estudiar el seu enfocament i, amb sort, segueixin incorporant-se al creixent conjunt de treballs de modelatge realitzats al camp.

Amb l'accés a les màquines de pròxima generació, l'equip espera generar models 4D globals a aquest nivell de precisió i incorporar cada vegada més dades més complexes com ara tipus de sediments al voltant dels edificis. Aquests conjunts de dades globals donarien lloc a un gran salt per a la investigació de la geografia urbana, així com a ajudar els planificadors de la ciutat, els responsables de prendre decisions i els grups d'interès a prendre decisions més informades. Juntament amb el suport de GCS, Zhu ha aconseguit recentment una subvenció de 1,5 milions d'euros per donar suport a la seva recerca cap a aquest objectiu, i el projecte de subvenció del Consell Europeu de Recerca So2Sat va començar l'1 de setembre de 2017.

Font: PHYSorg

Un equip d'investigadors liderats pel professor Xiaoxiang Zhu, de la Universitat Tècnica de Munich (TUM), va reconèixer que el modelatge amb precisió de les ciutats per a propòsits de gestió de riscos necessitaven una quarta dimensió: el temps. Per posar-ho en marxa amb una alta resolució d'un model tridimensional, l'equip necessitava l'ajuda de superordinadors.

"Els models estàtics tridimensionals de les ciutats estan ben establerts, sobretot a Europa", va dir Zhu. "El que ara treballem en la mesura dels canvis temporals és fins a l'escala de centímetre o mil·límetre per observar si les àrees d'edificis s'han vist pertorbades per l'augment o la disminució".

L'augment i la subsidència són el moviment de la superfície de la Terra en funció de les condicions canviants subterrànies, poden moure les estructures cap amunt (augment) o cap avall (subsidència). Utilitzant algunes de les tecnologies d'imatges de satèl·lit més avançades a la Terra i la màquina SuperMUC del Centre de Supercomputació de Leibniz (LRZ), l'equip de Zhu pren fotografies satel·litals d'aquests petits canvis, i després utilitza aquestes imatges per fer models computacionals en moviment.

En el procés, l'equip va reconstruir el primer model que il·lustra tota una ciutat en quatre dimensions. La investigació de l'equip va rebre el millor premi paper de les transaccions IEEE sobre Geoscience i teledetecció l'estiu passat.

Reconstrucció de riscos de construcció

La investigació de l'equip comença per sobre dels núvols. Usant alguns dels satèl·lits d'observació civil més avançats disponibles, com ara TerraSAR-X i TanDEM-X del Centre Aeroespacial Alemany (DLR), el grup utilitza un mètode anomenat tomografia SAR (TomoSAR) per obtenir les seves imatges en 3D.

Per mesurar els canvis dels edificis, aquests satèl·lits han de disparar ones a la superfície de la terra, alhora que mesuren la distància entre el satèl·lit i els edificis de la zona en qüestió: com més curta sigui la longitud d'ona, més precises són les mesures. L'equip Zhu utilitza imatges creades amb ones de 3 centímetres.

El satèl·lit triga uns 11 dies a revisar el mateix lloc a la Terra, després pren una imatge des d'una posició una mica diferent, permetent als investigadors combinar aquestes imatges en un model 3D. A més, atès que les imatges es prenen en diferents moments, aquestes mesures precises permeten als investigadors buscar "paràmetres de deformació" observant fins i tot els canvis més mínims -en aquest context, l'anomenada quarta dimensió- a la distància de l'edifici del satèl·lit.

Els investigadors es posen a treballar per posar aquestes imatges en moviment. Cada imatge és aproximadament 10,000 per 5.000 píxels, i l'equip ha de fer càlculs per a cada píxel. L'equip ha treballat en conjunts de dades per a diverses ciutats -Las Vegas, Berlín, Xangai, Beijing, Washington DC i París- i té conjunts de dades que van des d'aproximadament 25 imatges fins a 550.

El mètode de detecció de compressió de l'equip és una de les claus en la generació d'aquests models de 4D d'alta qualitat. En termes simples, mitjançant l'ús de la detecció compressiva, els investigadors es beneficien de la sparsity del model o el fet que només estiguin recreant un model tridimensional de la superfície de la Terra en lloc del volum sencer del planeta. Això permet als investigadors augmentar la resolució en els seus models fins a 25 vegades el que podrien fer simulant el volum de la Terra.

"Els preus que vam pagar per aquests models de ciutats 4D precisos i rècord mundials són despeses computacionals", va dir Zhu. "Per a cada píxel, estem resolent un costós problema d'optimització convexa amb una dimensió de centenars de milions de vegades. Això només és possible amb una informàtica d'alt rendiment".

L'equip va utilitzar 26 milions d'hores bàsiques en el sistema SuperMUC de LRZ. Aquests models són molt intensius en la memòria, i l'equip utilitza l'illa greix de SuperMUC, de manera que podria centrar les seves reconstruccions en els 8.200 nuclis de la màquina amb una memòria molt alta per nucli.

Ronda i volta

Com que va ser el primer equip a crear models 4D a partir de dades d'imatges de satèl·lit, l'equip ha ajudat a començar un camí per obtenir mètodes més detallats i de vigilància de la ciutat. En crear els seus diferents models de ciutats, l'equip va descobrir que el centre de convencions de Las Vegas mostrava una disminució notable, i el sòl s'enfonsava aproximadament a 30 mil·límetres per any en alguns llocs.

A mesura que les ciutats continuen augmentant i arriben a ser cada cop més poblades, es prenen imatges d'alta resolució de l'espai i el poder informàtic continua creixent, l'equip confia que els seus mètodes s'utilitzaran amb més freqüència, cosa que conduirà a treballs de construcció més segurs i avançats, avís d'edificis que comencen a mostrar signes de risc estructural i, al seu torn, perill.

L'equip ha estat guardonat amb una altra assignació de l'equip GCS per al 2017, que rep 20 milions d'hores bàsiques en el sistema SuperMUC de LRZ. Zhu va indicar que l'equip va planificar obrir els conjunts de dades de l'equip a la comunitat perquè altres investigadors poguessin estudiar el seu enfocament i, amb sort, segueixin incorporant-se al creixent conjunt de treballs de modelatge realitzats al camp.

Amb l'accés a les màquines de pròxima generació, l'equip espera generar models 4D globals a aquest nivell de precisió i incorporar cada vegada més dades més complexes com ara tipus de sediments al voltant dels edificis. Aquests conjunts de dades globals donarien lloc a un gran salt per a la investigació de la geografia urbana, així com a ajudar els planificadors de la ciutat, els responsables de prendre decisions i els grups d'interès a prendre decisions més informades. Juntament amb el suport de GCS, Zhu ha aconseguit recentment una subvenció de 1,5 milions d'euros per donar suport a la seva recerca cap a aquest objectiu, i el projecte de subvenció del Consell Europeu de Recerca So2Sat va començar l'1 de setembre de 2017.

Font: PHYSorg

Etiquetes de comentaris:

3D,

Ciutats,

satèl·lits

Ubicació:

Granollers, Barcelona, Espanya

Un nou tipus de nanosensor òptic utilitza el parell per al processament del senyal

El món dels nanosensors pot ser físicament petit, però la demanda és gran i creixent, amb poca senyal de desacceleració. A mesura que els dispositius electrònics són més petits, la seva capacitat de proporcionar una detecció precisa i basada en xips de propietats físiques dinàmiques com el moviment, esdevé un desafiament per desenvolupar-se.

Un grup internacional d'investigadors ha fet un gir literal en aquest repte, demostrant un nou ressonador optomecànic a escala nanomètrica que pot detectar moviment torsional en la sensibilitat més avançada de l'estat de la tècnica. El seu ressonador, en el qual es relaciona la llum, també demostra la barreja de freqüència torsional, una nova capacitat per impactar energies òptiques usant moviments mecànics.

"Amb l'evolució de la nanotecnologia, la capacitat de mesurar i controlar el moviment torsional a la nanoescala pot ser una poderosa eina per explorar la natura", va dir Jianguo Huang de la Universitat de Xi'an Jiaotong a Xina, un dels autors del treball. També és afiliat a la Universitat Tecnològica de Nanyang i a l'Institut de Microelectrònica, A * STAR a Singapur. "Presentem un nou disseny de cavitats en cavitat en el qual un ressonador mecànic torsional està incrustat en una cavitat òptica de pista, per demostrar la sensació de moviment torsional a escala nanomètrica".

La llum ja s'ha utilitzat de manera semblant a la detecció de la flexió mecànica o respiració de nanomaterials, que solen requerir un acoblament complex i sensible a la font de llum. Aquest nou enfocament no només és nou en la detecció de parells de nanoescala, sinó també en el seu disseny d'acoblament de llum integrat.

Mitjançant un mètode de nanofabricació basat en el silici, Huang i el seu equip van dissenyar el dispositiu per permetre que la llum s'adhereixi directament a través d'una reixeta dentada a una configuració de guia d'ona, anomenada cavitat de ròtula, en la qual s'assenta el nanoresonador.

"A mesura que la llum s'acobla a la cavitat de la pista a través d'un acoblador de reixeta, el moviment torsional mecànic a la cavitat altera la propagació de la llum i canvia la potència de la llum de sortida", va dir Huang. "Detectant la petita variació de la llum de sortida, es poden mesurar els moviments torsionals".

Més enllà de la detecció de parells en els seus braços de palanca de longitud de micra, els ressonadors també poden afectar les propietats òptiques resultants del senyal incident. La freqüència torsional del sistema mecànic es barreja amb els senyals òptics modulats.

"La part més sorprenent és que quan modifiquem la llum d'entrada, podem observar la barreja de freqüència", va dir Huang. "És emocionant per a la barreja de freqüències, ja que només s'ha demostrat per modes de flexió o respiració. Aquesta és la primera demostració de la barreja de freqüència torsional, que pot tenir conseqüències per a la modulació del senyal RF en xip, com ara receptors super heterodinos utilitzant òptica ressonadors mecànics".

Aquest és només el començament dels usos potencials dels nanosensors basats en parell. Teòricament, hi ha una sèrie de trucades de freqüència que aquests dispositius podrien tenir per a processos de processament i detecció de senyals.

"Seguirem explorant caràcters únics d'aquest sensor optomecànic torsional i intentarem demostrar nous fenomens, com la inferència d'un acoblament optomecànic dispersiu i dissipatiu amagat darrere de la detecció", va dir Huang. "Pel que fa a l'enginyeria, els materials magnètics o elèctricament sensibles es poden recobrir a la superfície de les bigues torsionals per detectar petites variacions de camps físics, com ara camps magnètics o elèctrics que serveixen de sensors multifuncionals".

Font: PHYSorg

Un grup internacional d'investigadors ha fet un gir literal en aquest repte, demostrant un nou ressonador optomecànic a escala nanomètrica que pot detectar moviment torsional en la sensibilitat més avançada de l'estat de la tècnica. El seu ressonador, en el qual es relaciona la llum, també demostra la barreja de freqüència torsional, una nova capacitat per impactar energies òptiques usant moviments mecànics.

"Amb l'evolució de la nanotecnologia, la capacitat de mesurar i controlar el moviment torsional a la nanoescala pot ser una poderosa eina per explorar la natura", va dir Jianguo Huang de la Universitat de Xi'an Jiaotong a Xina, un dels autors del treball. També és afiliat a la Universitat Tecnològica de Nanyang i a l'Institut de Microelectrònica, A * STAR a Singapur. "Presentem un nou disseny de cavitats en cavitat en el qual un ressonador mecànic torsional està incrustat en una cavitat òptica de pista, per demostrar la sensació de moviment torsional a escala nanomètrica".

La llum ja s'ha utilitzat de manera semblant a la detecció de la flexió mecànica o respiració de nanomaterials, que solen requerir un acoblament complex i sensible a la font de llum. Aquest nou enfocament no només és nou en la detecció de parells de nanoescala, sinó també en el seu disseny d'acoblament de llum integrat.

Mitjançant un mètode de nanofabricació basat en el silici, Huang i el seu equip van dissenyar el dispositiu per permetre que la llum s'adhereixi directament a través d'una reixeta dentada a una configuració de guia d'ona, anomenada cavitat de ròtula, en la qual s'assenta el nanoresonador.

"A mesura que la llum s'acobla a la cavitat de la pista a través d'un acoblador de reixeta, el moviment torsional mecànic a la cavitat altera la propagació de la llum i canvia la potència de la llum de sortida", va dir Huang. "Detectant la petita variació de la llum de sortida, es poden mesurar els moviments torsionals".

Més enllà de la detecció de parells en els seus braços de palanca de longitud de micra, els ressonadors també poden afectar les propietats òptiques resultants del senyal incident. La freqüència torsional del sistema mecànic es barreja amb els senyals òptics modulats.

"La part més sorprenent és que quan modifiquem la llum d'entrada, podem observar la barreja de freqüència", va dir Huang. "És emocionant per a la barreja de freqüències, ja que només s'ha demostrat per modes de flexió o respiració. Aquesta és la primera demostració de la barreja de freqüència torsional, que pot tenir conseqüències per a la modulació del senyal RF en xip, com ara receptors super heterodinos utilitzant òptica ressonadors mecànics".

Aquest és només el començament dels usos potencials dels nanosensors basats en parell. Teòricament, hi ha una sèrie de trucades de freqüència que aquests dispositius podrien tenir per a processos de processament i detecció de senyals.

"Seguirem explorant caràcters únics d'aquest sensor optomecànic torsional i intentarem demostrar nous fenomens, com la inferència d'un acoblament optomecànic dispersiu i dissipatiu amagat darrere de la detecció", va dir Huang. "Pel que fa a l'enginyeria, els materials magnètics o elèctricament sensibles es poden recobrir a la superfície de les bigues torsionals per detectar petites variacions de camps físics, com ara camps magnètics o elèctrics que serveixen de sensors multifuncionals".

Font: PHYSorg

Etiquetes de comentaris:

nanosensors

Ubicació:

Granollers, Barcelona, Espanya

El 'deep learning' en poques paraules

Abans d'entrar en el deep learning, cal fer un pas enrere i parlar una mica sobre el camp més ampli de aprenentatge automàtic i què significa que s'està programant màquines per què aprenguin. De vegades sorgeixen problemes per als quals és molt difícil escriure un programa informàtic per resoldre's. Per exemple, voler programar una computadora per reconèixer dígits escrits a mà:

Es podria imaginar tractar d'idear un conjunt de regles per distingir cada dígit individual. Els zeros, per exemple, són bàsicament un circuit tancat. Però, què passa si la persona no tanca perfectament el bucle. O què passa si la part superior dreta del cercle tanca per sota d'on comença la part superior esquerra del cicle?

En aquest cas, sorgeixen dificultats per diferenciar zeros de sisos. Es podria establir algun tipus de tall, però, com decidir el tall en primer lloc?. Com es pot veure, es fa bastant complicat compilar una llista heurística (és a dir, regles i conjectures) que classifiquen amb precisió els dígits manuscrits. I hi ha tantes classes de més problemes que entren en aquesta categoria. Reconèixer objectes, comprendre conceptes, comprendre el discurs. No se sap quin programa escriure, perquè encara no se sap com ho fan els nostres propis cervells. I fins i tot si es tenia una bona idea sobre com fer-ho, el programa podria ser horriblement complicat.

Així que, en comptes d'intentar escriure un programa, s'intenta desenvolupar un algoritme que un ordinador pugui utilitzar per mirar centenars o milers d'exemples (i les respectives respostes correctes), i després l'ordinador utilitza aquesta experiència per resoldre el mateix problema en situacions noves. Essencialment, l'objectiu és ensenyar a l'ordinador a resoldre, per exemple, d'una manera molt similar a com es pot ensenyar a un nen petit a distingir un gat d'un gos.

Durant les últimes dècades, els científics informàtics han desenvolupat una sèrie d'algorismes que intenten permetre que els ordinadors aprenguin a resoldre problemes a través d'exemples. L'aprenentatge profund, que va ser teoritzat per primera vegada a principis dels 80 (i potser fins i tot abans), és un paradigma per a la realització de l'aprenentatge automàtic. I a causa d'una sèrie d'investigacions modernes, l'aprenentatge profund torna a augmentar, ja que s'ha demostrat que és bastant bo per ensenyar a les computadores a fer el que el nostre cervell pot fer de forma natural.

Un dels grans reptes amb els models tradicionals d'aprenentatge automàtic és un procés anomenat extracció de característiques. Concretament, el programador necessita informar a l'ordinador quins tipus de coses hauria de buscar, serà informatiu en la presa de decisions. L'alimentació de l'algorisme de dades en brut rares vegades funciona, de manera que l'extracció de característiques és una part crítica del flux de treball tradicional de l'aprenentatge de màquina. Això suposa una gran càrrega per al programador, i l'eficàcia de l'algoritme es basa en gran mesura en què és el programador més atractiu. Per a problemes complexos com el reconeixement d'objectes o el reconeixement d'escriptura manual, aquest és un repte enorme.

L'aprenentatge profund és un dels únics mètodes pels quals podem evitar els reptes de l'extracció de funcions. Això és degut a que els models d'aprenentatge profund són capaços d'aprendre a centrar-se en les característiques correctes per si mateixos, que requereixen poca orientació del programador. Això fa que l'aprenentatge profund sigui una eina extremadament poderosa per a l'aprenentatge automàtic modern.

Una primera mirada a xarxes neuronals

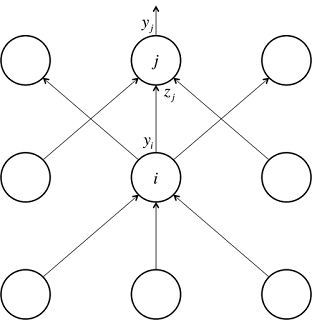

L'aprenentatge profund és una forma d'aprenentatge automàtic que utilitza un model de computació molt inspirat en l'estructura del cervell. Per això, s'anomena aquest model una xarxa neuronal. La unitat bàsica fonamental d'una xarxa neuronal és la neurona, que en realitat és, conceptualment, bastant simple.

Cada neurona té un conjunt d'entrades, cadascuna d'elles té un pes específic. La neurona calcula alguna funció en aquestes entrades ponderades. Una neurona lineal pren una combinació lineal de les entrades ponderades. Una neurona sigmoidea fa alguna cosa una mica més complicada:

Alimenta la suma ponderada de les entrades a la funció logística. La funció logística retorna un valor entre 0 i 1. Quan la suma ponderada és molt negativa, el valor retornat és molt proper a 0. Quan la suma ponderada és molt gran i positiva, el valor retornat és molt proper a 1. Per a més matemàticament inclinat, la funció logística és una bona elecció perquè té una bonica derivació, que fa que l'aprenentatge sigui un procés més senzill. Però a banda de les dades tècniques, independentment de la funció que utilitzi la neurona, el valor que calcula es transmet a altres neurones com a sortida. A la pràctica, les neurones sigmoides s'utilitzen molt més sovint que les neurones lineals, ja que permeten algorismes d'aprenentatge molt més versàtils en comparació amb les neurones lineals.

Una xarxa neuronal es produeix quan comencem a connectar les neurones entre elles, a les dades d'entrada i als punts de venda, que corresponen a la resposta de la xarxa al problema de l'aprenentatge. Per facilitar la visualització d'aquesta estructura, he inclòs un exemple senzill d'una xarxa neuronal a continuació. Deixem que w(k) i, j sigui el pes de l'enllaç que uneix la neurona ith a la kth capa amb la jth neurona a la capa k + 1 st:

De manera similar a com les neurones generalment s'organitzen en capes del cervell humà, les neurones de les xarxes neuronals també s'organitzen en capes, on les de la capa inferior reben senyals de les entrades; on les de les capes superiors tenen les seves connexions connectades amb la resposta i on normalment no hi ha connexions entre neurones en la mateixa capa (tot i que aquesta és una restricció opcional, les connectivitats més complexes requereixen més anàlisi matemàtica). També s'observen que, en aquest exemple, no hi ha connexions que condueixen des d'una neurona en una capa superior a una neurona en una capa inferior (és a dir, sense cicles dirigits). Aquestes xarxes neuronals s'anomenen xarxes neuronals avançades en comparació amb les seves contraparts, que es diuen recursives xarxes neuronals (de nou són molt més complicades d'analitzar i entrenar). Per fer-ho més fàcil, només ens centrem en les xarxes avançades al llarg d'aquesta discussió. Seguidament us oferim un conjunt d'algunes notes més importants per tenir en compte:

Formar una neurona individual

Les coses comencen a posar-se interessants, però encara falta un gran tros de la imatge. Se sap com una xarxa neuronal pot calcular les respostes de les entrades, però s'ha assumit que sap quins pesos utilitzar per començar. Esbrinar quins pesos ha de ser la part més difícil del problema, i això es fa mitjançant un procés anomenat entrenament. Durant l'entrenament, es mostren a la xarxa neuronal una gran quantitat d'exemples de formació i es modifiquen de forma iterativa els pesos per minimitzar els errors que fem sobre els exemples de formació.

Començar amb un exemple senzill que implica una única neurona lineal per motivar el procés. Cada dia es menja al menjador on el menjar està format per hamburgueses, patates fregides i refrescos. Es compren un nombre de porcions de cada element. Es vol poder predir quant costarà el menjar, però no es coneixen els preus de cada element individual. L'únic que dirà el caixer és el preu total del menjar.

Com es pot solucionar aquest problema? Bé, Es podria començar per ser intel·ligents per escollir els casos de formació. Per a un dinar es podria comprar només una sola porció d'hamburgueses, per a un altre només es podria comprar una sola porció de patates fregides, i després per al nostre últim sopar es podria comprar una sola porció de refresc. En general, triar casos de formació intel·ligent és una bona idea. Hi ha molta investigació que demostra que mitjançant l'enginyeria d'un conjunt de formació intel·ligent, es podria aconseguir que la xarxa neuronal sigui molt més eficaç. El problema amb aquest enfocament és que en situacions reals, això rarament obté un 10% del l'èxit del resultat. Per exemple, quin és l'anàleg d'aquesta estratègia en el reconeixement d'imatges?

Suposant que es te un munt d'exemples de formació, a continuació es pot calcular el que la xarxa neuronal generarà en l'exemple d'entrenament ith utilitzant la fórmula simple del diagrama. Es vol entrenar la neurona perquè es puguin triar els pesos òptims possibles: els pesos que minimitzen els errors que es fan sobre els exemples de formació. En aquest cas, diguem que es vol minimitzar l'error quadrat sobre tots els exemples d'entrenament que es trobaran. Més formalment, si se sap que t(i) és la resposta veritable per al i-èsim exemple d'entrenament e i(i) és el valor calculat per la xarxa neuronal, volem minimitzar el valor de la funció d'error E:

Ara, en aquest moment, es podria estar pensant, esperant ... Per què molestar-se amb aquesta funció d'error sense sentit quan es tenen un munt de variables (pesos) i es te un conjunt d'equacions (una per a cada exemple de formació)? No es podria solucionar aquest problema configurant un sistema lineal d'equacions? Això donaria automàticament un error de zero assumint que es te un conjunt consistent d'exemples de formació. Aquesta és una observació intel·ligent, però la perspicàcia, malauradament, no generalitza bé. Recordar que, tot i que s'està utilitzant una neurona lineal aquí, aquestes, no s'utilitzen gaire a la pràctica, ja que es limiten al que poden aprendre. Per tant, ara es el moment de començar a utilitzar neurones no lineals com les neurones sigmoides comentades abans.

Per tant, potser es pot utilitzar un enfocament iteratiu que generalitzi en exemples no lineals. S'intenta visualitzar com es podria minimitzar l'error quadrat en tots els exemples d'entrenament simplificant el problema. Diguem que s'està tractant amb una neurona lineal amb només dues entrades (i, per tant, només dos pesos, w1 i w2). A continuació, es pot imaginar un espai tridimensional on les dimensions horitzontals corresponen als pesos w1 i w2, i hi ha una dimensió vertical que correspon al valor de la funció d'error E. Així, en aquest espai, els punts del pla horitzontal corresponen a la configuració diferent dels pesos i l'alçada en aquests punts corresponen a l'error en què estem incorrent, sumats en tots els casos de formació. Si es tenen en compte els errors que es fan sobre tots els pesos possibles, s'obté una superfície en aquest espai tridimensional.

També podem visualitzar convenientment aquesta superfície com un conjunt de contorns el·líptics, on l'error mínim es troba al centre de les el·lipsis:

Així doncs, diguem que s'està en algun lloc del pla horitzontal (escollint una inicialització aleatòria per als pesos). Com aconseguir el punt en el plànol horitzontal amb el menor valor d'error? Una estratègia és moure sempre de manera perpendicular a les línies de contorn. Per exemple, a la ruta indicada per les fletxes vermelles. Molt clar, es pot veure que, seguint aquesta estratègia, s'arribarà al punt d'error mínim. El que és particularment interessant és que moure's perpendicularment a les línies de contorn equival a prendre el camí del descens més pronunciat per la tassa parabòlica.

Aquest és un resultat bastant sorprenent del càlcul, i ens dóna el nom d'aquesta estratègia general per a la formació de xarxes neuronals: descens de gradient.

Tarifes d'aprenentatge i la regla del Delta

En la pràctica, a cada pas de moure's perpendicularment al contorn, s'ha de determinar fins a quin punt es vol caminar abans de tornar a calcular la nova adreça. Aquesta distància ha de dependre de la inclinació de la superfície. Per què? Com més a prop al mínim, més curts cal avançar. Sabent que s'està a prop del mínim, perquè la superfície és molt més plana, per la qual cosa es pot utilitzar la inclinació com a indicador de la proximitat que tenim al mínim. Es multiplica aquesta mesura d'inclinació amb un factor constant predeterminat ε, la taxa d'aprenentatge. Escollir la taxa d'aprenentatge és un problema difícil. Si es tria una taxa d'aprenentatge que és massa petita, hi ha el risc a prendre massa temps durant el procés de formació. Si es tria una taxa d'aprenentatge massa gran, probablement es començarà a divergir del mínim (això és bastant fàcil de visualitzar). Els algorismes d'entrenament moderns adapten la taxa d'aprenentatge per superar aquest difícil repte.

Posar totes les peces, es coneix com la regla delta per formar la neurona lineal. La regla delta estableix que donada una velocitat d'aprenentatge ε, cal canviar el pes wk en cada iteració de la formació de Δwk = Σiεxk (t (i) -y (i)). Derivar aquesta fórmula es deixa com un exercici per al lector experimentat.

Malauradament, simplement prenent el camí del descens més pronunciat, no sempre resol quan tenim neurones no lineals. La superfície d'error pot arribar a ser complicada i podria haver-hi un mínim local múltiple. Com a resultat, l'ús d'aquest procediment podria arribar a un mínim local que no és el mínim global. Com a resultat, en la pràctica, la formació de xarxes neuronals implica una modificació del descens de degradat anomenat descens gradient estocàstic, que intenta utilitzar l'aleatorització i el soroll per trobar el mínim global amb una alta probabilitat en una superfície d'error complexa. Passant a la neurona sigmoidea.

Aquesta secció i la següent es tornaran una mica pesades amb les matemàtiques, així que acaba de ser previngut. Si no us trobeu còmode amb el càlcul multivariant, no dubti a saltar-los i passar a les seccions restants. En cas contrari, anem a submergir-hi bé!

Recordant el mecanisme pel qual les neurones logístiques computen el valor de sortida de les seves entrades:

A més, sorprenentment, la derivada de la sortida respecte al logit és bastant simple si s'expressa en termes de sortida.

Llavors usant la regla de la cadena per obtenir la derivada de la sortida respecte a cada pes:

Posant tot això junt, ara es pot calcular la derivada de la funció d'error respecte a cada pes:

Per tant, la regla final per a la modificació dels pesos es converteix en:

Com es pot observar, la nova regla de modificació és igual que la delta, excepte amb els termes multiplicatius addicionals inclosos per explicar el component logístic de la neurona sigmoidea.

L'algoritme de backpropagation

Ara estem preparats per abordar el problema de la formació de xarxes neuronals multicapa (en lloc de només neurones individuals). Quina és la idea? No se sap què haurien de fer les unitats ocultes, però el que es pot fer és calcular la rapidesa amb que l'error canvia a mesura que es canvia una activitat oculta. Essencialment intentant trobar el camí del descens més fort.

Cada unitat oculta pot afectar moltes unitats de sortida. Per tant, s'haurien de combinar molts efectes separats sobre l'error d'una manera informativa. La nostra serà una estratègia de programació dinàmica. Un cop es tinguin els derivats d'error per una capa d'unitats ocultes, seran utilitzades per calcular els derivats d'error per a les activitats de la capa següent. I una vegada que es trobin els derivats d'error per a les activitats de les unitats ocultes, és molt fàcil obtenir els derivats d'error dels pesos que condueixen a una unitat oculta. Es tornarà a definir una notació per facilitar la discussió i es fa referència al següent diagrama:

El subíndex que s'utilitza es referirà a la capa de la neurona. El símbol y es referirà a l'activitat d'una neurona, com de costum. De la mateixa manera, el símbol z es referirà al logit d'una neurona. Comencem donant una ullada al cas bàsic del problema de programació dinàmica, els derivats de la funció d'error a la capa de sortida:

Ara cal abordar el pas inductiu. Suposant que es tenen els derivats d'error per a la capa j. Ara es te la intenció de calcular els derivats d'error per a la capa que hi ha a sota, capa i. Per fer-ho, cal acumular informació sobre com la producció d'una neurona en la capa I afecta els logits de cada neurona en la capa j. Això es pot fer de la següent manera, utilitzant el fet que la derivada parcial del logit respecte a les dades de sortida entrants de la capa inferior no és més que el pes de la connexió w ij:

Ara es pot utilitzar el següent per completar el pas inductiu:

Combinant aquests dos conjunts, finalment es poden expressar els derivats parcials de la capa i en termes de les derivades parcials de la capa j. A continuació, una vegada que s'hagi passat tota la rutina de programació dinàmica, havent omplert la taula adequadament amb totes les derivades parcials (de la funció d'error respecte a les activitats de la unitat oculta), llavors es pot determinar com canvia l'error respecte als pesos.

Això dona com modificar els pesos després de cada exemple d'entrenament:

Per fer la preparació de la preparació d'una combinació d'exemples d'entrenament, només es resumeixen les derivades parcials sobre tots els exemples de formació del lot. Això dóna la següent fórmula de modificació:

S'ha aconseguit obtenir l'algoritme de backpropagation per a una xarxa neuronal avançada que utilitza neurones sigmoïdals.

El problema de l'excessiu

Ara, volem tractar d'entrenar una xarxa neuronal per identificar objectes en una imatge. Sabent que aquest és un problema complicat perquè cal utilitzar una gran xarxa neuronal (diguem-ne 20 capes) i tenim 1.000 exemples de formació. Entrenar la xarxa neuronal utilitzant l'algoritme que es descriurà, però hi ha alguna cosa que és clarament incorrecte. La xarxa neural funciona pràcticament a la perfecció en els exemples d'entrenament, però quan es passa a la pràctica, es comporta molt malament. Que està passant aquí?

El problema que s'ha detectat es diu excessiu, i això passa quan hi ha massa paràmetres al model i no hi ha prou dades d'entrenament. Per visualitzar-ho, tenint en compte la figura següent, es vol adaptar a un model als punts de dades:

Quina corba cal escollir? La línia que pràcticament no té cap exemple d'entrenament exactament? O la complicada corba que toca cada punt del conjunt de formació? Probablement caldria confiar en l'ajustament lineal en comptes de la complicada corba perquè sembla menys complicada. Aquesta situació és anàloga a la xarxa neuronal que s'ha format. Es tenen massa paràmetres, més de 100 bilions de bilions de dòlars (o 100ptilions) de paràmetres. Llavors, com evitarem l'excessiu?

Les dues maneres més senzilles són:

Hi ha mètodes de formació més sofisticats que tracten de resoldre directament la sobreintegració, com ara la inclusió d'unes capes / neurones abandonades, però aquests mètodes estan fora de l'abast d'aquest article.

Font: KDnuggets

|

| Imatge proporcionada per la base de dades manuscrita MNIST |

En aquest cas, sorgeixen dificultats per diferenciar zeros de sisos. Es podria establir algun tipus de tall, però, com decidir el tall en primer lloc?. Com es pot veure, es fa bastant complicat compilar una llista heurística (és a dir, regles i conjectures) que classifiquen amb precisió els dígits manuscrits. I hi ha tantes classes de més problemes que entren en aquesta categoria. Reconèixer objectes, comprendre conceptes, comprendre el discurs. No se sap quin programa escriure, perquè encara no se sap com ho fan els nostres propis cervells. I fins i tot si es tenia una bona idea sobre com fer-ho, el programa podria ser horriblement complicat.

Així que, en comptes d'intentar escriure un programa, s'intenta desenvolupar un algoritme que un ordinador pugui utilitzar per mirar centenars o milers d'exemples (i les respectives respostes correctes), i després l'ordinador utilitza aquesta experiència per resoldre el mateix problema en situacions noves. Essencialment, l'objectiu és ensenyar a l'ordinador a resoldre, per exemple, d'una manera molt similar a com es pot ensenyar a un nen petit a distingir un gat d'un gos.

Durant les últimes dècades, els científics informàtics han desenvolupat una sèrie d'algorismes que intenten permetre que els ordinadors aprenguin a resoldre problemes a través d'exemples. L'aprenentatge profund, que va ser teoritzat per primera vegada a principis dels 80 (i potser fins i tot abans), és un paradigma per a la realització de l'aprenentatge automàtic. I a causa d'una sèrie d'investigacions modernes, l'aprenentatge profund torna a augmentar, ja que s'ha demostrat que és bastant bo per ensenyar a les computadores a fer el que el nostre cervell pot fer de forma natural.

Un dels grans reptes amb els models tradicionals d'aprenentatge automàtic és un procés anomenat extracció de característiques. Concretament, el programador necessita informar a l'ordinador quins tipus de coses hauria de buscar, serà informatiu en la presa de decisions. L'alimentació de l'algorisme de dades en brut rares vegades funciona, de manera que l'extracció de característiques és una part crítica del flux de treball tradicional de l'aprenentatge de màquina. Això suposa una gran càrrega per al programador, i l'eficàcia de l'algoritme es basa en gran mesura en què és el programador més atractiu. Per a problemes complexos com el reconeixement d'objectes o el reconeixement d'escriptura manual, aquest és un repte enorme.

L'aprenentatge profund és un dels únics mètodes pels quals podem evitar els reptes de l'extracció de funcions. Això és degut a que els models d'aprenentatge profund són capaços d'aprendre a centrar-se en les característiques correctes per si mateixos, que requereixen poca orientació del programador. Això fa que l'aprenentatge profund sigui una eina extremadament poderosa per a l'aprenentatge automàtic modern.

Una primera mirada a xarxes neuronals

L'aprenentatge profund és una forma d'aprenentatge automàtic que utilitza un model de computació molt inspirat en l'estructura del cervell. Per això, s'anomena aquest model una xarxa neuronal. La unitat bàsica fonamental d'una xarxa neuronal és la neurona, que en realitat és, conceptualment, bastant simple.

Cada neurona té un conjunt d'entrades, cadascuna d'elles té un pes específic. La neurona calcula alguna funció en aquestes entrades ponderades. Una neurona lineal pren una combinació lineal de les entrades ponderades. Una neurona sigmoidea fa alguna cosa una mica més complicada:

Alimenta la suma ponderada de les entrades a la funció logística. La funció logística retorna un valor entre 0 i 1. Quan la suma ponderada és molt negativa, el valor retornat és molt proper a 0. Quan la suma ponderada és molt gran i positiva, el valor retornat és molt proper a 1. Per a més matemàticament inclinat, la funció logística és una bona elecció perquè té una bonica derivació, que fa que l'aprenentatge sigui un procés més senzill. Però a banda de les dades tècniques, independentment de la funció que utilitzi la neurona, el valor que calcula es transmet a altres neurones com a sortida. A la pràctica, les neurones sigmoides s'utilitzen molt més sovint que les neurones lineals, ja que permeten algorismes d'aprenentatge molt més versàtils en comparació amb les neurones lineals.

Una xarxa neuronal es produeix quan comencem a connectar les neurones entre elles, a les dades d'entrada i als punts de venda, que corresponen a la resposta de la xarxa al problema de l'aprenentatge. Per facilitar la visualització d'aquesta estructura, he inclòs un exemple senzill d'una xarxa neuronal a continuació. Deixem que w(k) i, j sigui el pes de l'enllaç que uneix la neurona ith a la kth capa amb la jth neurona a la capa k + 1 st:

De manera similar a com les neurones generalment s'organitzen en capes del cervell humà, les neurones de les xarxes neuronals també s'organitzen en capes, on les de la capa inferior reben senyals de les entrades; on les de les capes superiors tenen les seves connexions connectades amb la resposta i on normalment no hi ha connexions entre neurones en la mateixa capa (tot i que aquesta és una restricció opcional, les connectivitats més complexes requereixen més anàlisi matemàtica). També s'observen que, en aquest exemple, no hi ha connexions que condueixen des d'una neurona en una capa superior a una neurona en una capa inferior (és a dir, sense cicles dirigits). Aquestes xarxes neuronals s'anomenen xarxes neuronals avançades en comparació amb les seves contraparts, que es diuen recursives xarxes neuronals (de nou són molt més complicades d'analitzar i entrenar). Per fer-ho més fàcil, només ens centrem en les xarxes avançades al llarg d'aquesta discussió. Seguidament us oferim un conjunt d'algunes notes més importants per tenir en compte:

- Encara que totes les capes tenen el mateix nombre de neurones en aquest exemple, no és necessari.

- No es requereix que una neurona tingui la seva sortida connectada a les entrades de cada neurona en la següent capa. De fet, seleccionant quines neurones es connecten a quines altres neurones de la capa següent és un art que prové de l'experiència. Permetre la connectivitat màxima amb més freqüència no resultarà en un excedent, un concepte que més endavant discutirem.

- Les entrades i sortides són representacions vectoritzades. Per exemple, es pot imaginar una xarxa neuronal on les entrades són els valors dels píxels RGB individuals en una imatge representada com a vector. L'última capa pot tenir dues neurones que corresponen a la resposta al nostre problema: [0,1] si la imatge conté un gos, [1,0] si la imatge conté un gat, [0,0] si no conté cap dels dos, i [1,1] si els conté a tots dos.

- Les capes de neurones que es troben intercalades entre la primera capa (capa d'entrada) i l'última capa de neurones (capa de sortida), s'anomenen capes ocultes. Això és perquè aquí és on la major part de la màgia està passant quan la xarxa neuronal intenta resoldre problemes. Fer una ullada a les activitats de les capes amagades pot dir-vos molt sobre les funcions que la xarxa ha après a l'extreure de les dades.

Formar una neurona individual

Les coses comencen a posar-se interessants, però encara falta un gran tros de la imatge. Se sap com una xarxa neuronal pot calcular les respostes de les entrades, però s'ha assumit que sap quins pesos utilitzar per començar. Esbrinar quins pesos ha de ser la part més difícil del problema, i això es fa mitjançant un procés anomenat entrenament. Durant l'entrenament, es mostren a la xarxa neuronal una gran quantitat d'exemples de formació i es modifiquen de forma iterativa els pesos per minimitzar els errors que fem sobre els exemples de formació.

Començar amb un exemple senzill que implica una única neurona lineal per motivar el procés. Cada dia es menja al menjador on el menjar està format per hamburgueses, patates fregides i refrescos. Es compren un nombre de porcions de cada element. Es vol poder predir quant costarà el menjar, però no es coneixen els preus de cada element individual. L'únic que dirà el caixer és el preu total del menjar.

Com es pot solucionar aquest problema? Bé, Es podria començar per ser intel·ligents per escollir els casos de formació. Per a un dinar es podria comprar només una sola porció d'hamburgueses, per a un altre només es podria comprar una sola porció de patates fregides, i després per al nostre últim sopar es podria comprar una sola porció de refresc. En general, triar casos de formació intel·ligent és una bona idea. Hi ha molta investigació que demostra que mitjançant l'enginyeria d'un conjunt de formació intel·ligent, es podria aconseguir que la xarxa neuronal sigui molt més eficaç. El problema amb aquest enfocament és que en situacions reals, això rarament obté un 10% del l'èxit del resultat. Per exemple, quin és l'anàleg d'aquesta estratègia en el reconeixement d'imatges?

Suposant que es te un munt d'exemples de formació, a continuació es pot calcular el que la xarxa neuronal generarà en l'exemple d'entrenament ith utilitzant la fórmula simple del diagrama. Es vol entrenar la neurona perquè es puguin triar els pesos òptims possibles: els pesos que minimitzen els errors que es fan sobre els exemples de formació. En aquest cas, diguem que es vol minimitzar l'error quadrat sobre tots els exemples d'entrenament que es trobaran. Més formalment, si se sap que t(i) és la resposta veritable per al i-èsim exemple d'entrenament e i(i) és el valor calculat per la xarxa neuronal, volem minimitzar el valor de la funció d'error E:

Ara, en aquest moment, es podria estar pensant, esperant ... Per què molestar-se amb aquesta funció d'error sense sentit quan es tenen un munt de variables (pesos) i es te un conjunt d'equacions (una per a cada exemple de formació)? No es podria solucionar aquest problema configurant un sistema lineal d'equacions? Això donaria automàticament un error de zero assumint que es te un conjunt consistent d'exemples de formació. Aquesta és una observació intel·ligent, però la perspicàcia, malauradament, no generalitza bé. Recordar que, tot i que s'està utilitzant una neurona lineal aquí, aquestes, no s'utilitzen gaire a la pràctica, ja que es limiten al que poden aprendre. Per tant, ara es el moment de començar a utilitzar neurones no lineals com les neurones sigmoides comentades abans.

Per tant, potser es pot utilitzar un enfocament iteratiu que generalitzi en exemples no lineals. S'intenta visualitzar com es podria minimitzar l'error quadrat en tots els exemples d'entrenament simplificant el problema. Diguem que s'està tractant amb una neurona lineal amb només dues entrades (i, per tant, només dos pesos, w1 i w2). A continuació, es pot imaginar un espai tridimensional on les dimensions horitzontals corresponen als pesos w1 i w2, i hi ha una dimensió vertical que correspon al valor de la funció d'error E. Així, en aquest espai, els punts del pla horitzontal corresponen a la configuració diferent dels pesos i l'alçada en aquests punts corresponen a l'error en què estem incorrent, sumats en tots els casos de formació. Si es tenen en compte els errors que es fan sobre tots els pesos possibles, s'obté una superfície en aquest espai tridimensional.

També podem visualitzar convenientment aquesta superfície com un conjunt de contorns el·líptics, on l'error mínim es troba al centre de les el·lipsis:

Així doncs, diguem que s'està en algun lloc del pla horitzontal (escollint una inicialització aleatòria per als pesos). Com aconseguir el punt en el plànol horitzontal amb el menor valor d'error? Una estratègia és moure sempre de manera perpendicular a les línies de contorn. Per exemple, a la ruta indicada per les fletxes vermelles. Molt clar, es pot veure que, seguint aquesta estratègia, s'arribarà al punt d'error mínim. El que és particularment interessant és que moure's perpendicularment a les línies de contorn equival a prendre el camí del descens més pronunciat per la tassa parabòlica.

Aquest és un resultat bastant sorprenent del càlcul, i ens dóna el nom d'aquesta estratègia general per a la formació de xarxes neuronals: descens de gradient.

Tarifes d'aprenentatge i la regla del Delta

En la pràctica, a cada pas de moure's perpendicularment al contorn, s'ha de determinar fins a quin punt es vol caminar abans de tornar a calcular la nova adreça. Aquesta distància ha de dependre de la inclinació de la superfície. Per què? Com més a prop al mínim, més curts cal avançar. Sabent que s'està a prop del mínim, perquè la superfície és molt més plana, per la qual cosa es pot utilitzar la inclinació com a indicador de la proximitat que tenim al mínim. Es multiplica aquesta mesura d'inclinació amb un factor constant predeterminat ε, la taxa d'aprenentatge. Escollir la taxa d'aprenentatge és un problema difícil. Si es tria una taxa d'aprenentatge que és massa petita, hi ha el risc a prendre massa temps durant el procés de formació. Si es tria una taxa d'aprenentatge massa gran, probablement es començarà a divergir del mínim (això és bastant fàcil de visualitzar). Els algorismes d'entrenament moderns adapten la taxa d'aprenentatge per superar aquest difícil repte.

Posar totes les peces, es coneix com la regla delta per formar la neurona lineal. La regla delta estableix que donada una velocitat d'aprenentatge ε, cal canviar el pes wk en cada iteració de la formació de Δwk = Σiεxk (t (i) -y (i)). Derivar aquesta fórmula es deixa com un exercici per al lector experimentat.

Malauradament, simplement prenent el camí del descens més pronunciat, no sempre resol quan tenim neurones no lineals. La superfície d'error pot arribar a ser complicada i podria haver-hi un mínim local múltiple. Com a resultat, l'ús d'aquest procediment podria arribar a un mínim local que no és el mínim global. Com a resultat, en la pràctica, la formació de xarxes neuronals implica una modificació del descens de degradat anomenat descens gradient estocàstic, que intenta utilitzar l'aleatorització i el soroll per trobar el mínim global amb una alta probabilitat en una superfície d'error complexa. Passant a la neurona sigmoidea.